Pour des principes juridiques de responsabilité adaptés à l’intelligence artificielle

Le groupe d’experts de haut niveau de la Commission européenne a publié ses Lignes directrices éthiques pour une intelligence artificielle digne de confiance. Quels en sont les tenants et aboutissants ? Peuvent-elles réellement promouvoir le développement responsable d’une IA susceptible de rassurer le consommateur ?

Le rapport confirme les craintes sur les dérives éthiques de l’IA sans réellement offrir de solution

La Commission européenne (DG Marché intérieur) a mis en place ce groupe pour promouvoir le développement de l’IA face à ses concurrents chinois et étasunien. L’investissement de l’Union européenne de 1,5 milliard d’euros d’ici 2020 est présenté comme un véritable changement. Ce document s’accompagne d’une autre publication définissant la notion d’IA.

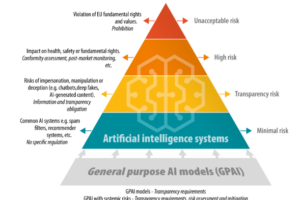

Comme dans le projet du 18 décembre les 52 membres tirent de nouveau la sonnette d’alarme sur les risques d’atteinte aux droits fondamentaux avec le score social et les systèmes d’armes létales automatisées.

En particulier, l’identification automatisée sur la base de données biométriques (micro-expressions, détection de la voix, reconnaissance faciale) pose la question de la validité du consentement à une telle surveillance ciblée ou de masse qui est sujette à caution : pour preuve, les consommateurs acceptent systématiquement les traceurs (cookies) et les conditions d’utilisation des services ou des applications mobiles sans réellement en mesurer les conséquences pratiques. Toutefois, ces craintes sont minimisées et placées au second plan derrière les impacts positifs d’ordre commercial (page 35 du document).

Pour toute réponse, les lignes directrices articulent 3 axes : le respect du droit applicable et des réglementations (sic), l’adhésion à des valeurs et principes éthiques et la robustesse technique et sociale des systèmes d’IA.

Les principes éthiques et valeurs sont directement issus de la Charte des Droits Fondamentaux de l’Union européenne (art.24 à 27 et 38). S’en suivent sept principes ou conditions que les systèmes d’IA devraient respecter pour renforcer cette confiance :

- La supervision par un être humain,

- La robustesse et la sécurité,

- La vie privée et la gouvernance,

- La transparence,

- La diversité, la non-discrimination et la justice,

- Le bien-être sociétal et environnemental,

- L’obligation de rendre des comptes.

Vers un label éthique de l’IA ? #OuPas

Chaque condition est explicitée afin que les fabricants d’IA (auteurs du texte) puissent s’y conformer sur une base volontaire.

Cet été, la Commission européenne lancera une phase pilote impliquant de nombreuses parties prenantes. Dès aujourd’hui, les entreprises, les administrations publiques et les organisations peuvent souscrire à l’Alliance européenne de l’IA et ainsi et y participer jusqu’à 2020.

Le groupe d’expert révisera ces conditions sur la base des feedbacks obtenus, et la Commission européenne proposera des actions en conséquence.

Cette expérimentation n’a pas pour vocation de créer de nouvelles règles éthiques, ou des normes spécifiques à l’IA, mais de simplement observer comment les entreprises peuvent appliquer ces conditions. Des mesures techniques et non-techniques sont proposées pour les mettre en œuvre : éthique et respect du droit dès la conception, méthodes d’explication, indicateurs qualitatifs, codes de conduite, certification…

En ce qui concerne l’obligation de rendre des comptes (accountability), il est proposé de procéder à l’audit des algorithmes tout en préservant le secret des affaires, le modèle économique et les droits de propriété intellectuelle associés à la technologie. Le questionnaire d’évaluation de l’« IA de confiance » proposé serait mis en œuvre à tous les niveaux de management de la direction aux responsables de projets, en passant par les RH, le juridique et le contrôle qualité.

Ces éléments pourraient servir d’architecture à un label de l’IA permettant de guider les consommateurs et donc de renforcer leur confiance. Encore faudrait-il que les entreprises acceptent d’être auditées par un organisme indépendant.

Le secteur de la santé connectée (ou mobile) est justement confronté à cette problématique : l’absence de label étatique a laissé la place à des initiatives privées dépourvues de reconnaissance mutuelle au-delà du territoire national. Or, par définition, les systèmes d’IA s’affranchissent des frontières ! Cette possibilité n’a pas été envisagée par les membres de ce groupe d’experts majoritairement composé d’industriels qui ne vont pas scier la branche sur laquelle ils sont assis !

Que fait le Groupe d’experts sur la responsabilité et les nouvelles technologies ?

Ces lignes directrices n’indiquent pas comment l’Union européenne pourrait apaiser ces craintes bien réelles d’une IA biaisée, discriminatoire ou potentiellement létale.

Adoptées par un groupe d’« experts », leur force juridique est inexistante. Elles n’ont aucune valeur juridique et ne peuvent initier le processus législatif qui reste une prérogative de la Commission.

Pendant ce temps, depuis juin 2018, le Groupe d’experts sur la responsabilité et les nouvelles technologies assiste la Commission européenne (DG Justice et Consommateurs) grâce à son expertise juridique, académique, en vue de développer des principes qui serviront de base à une adaptation du droit applicable au niveau européen et des États membres.

Dans le cadre de mes activités au sein de ce groupe d’experts, j’observe que l’éthique guide nos travaux qu’il s’agisse de véhicules autonomes, maison intelligente, robots-chirurgiens, drones… Or, l’analyse des systèmes de responsabilité existants dans les États membres révèle justement que l’absence de transparence algorithmique crée un déséquilibre significatif entre le consommateur et le fabricant (ou prestataire) de la technologie. Nos recommandations, juridiques, seront publiées en juin.

Je présenterai ce jeudi mon rapport sur les enjeux de cyber-sécurité qui ne sont pas adressés par l’état actuel du droit positif. Un grand chantier va donc s’ouvrir, sur lequel la France a une carte à jouer pour devenir la championne de l’IA.

Cet article a initialement été publié sur le site The Conversation.